При побудові і обслуговуванні інфраструктури такого масштабу потрібно враховувати масу параметрів, серед яких навіть самий незначний на перший погляд може кардинально вплинути на сукупну вартість володіння (total cost of ownership, tco), до мінімізації якої прагнуть всі гіперкейлери. Як відбувається процес вибору обладнання і чому вирішили спробувати систему рідинного охолодження (сжо) в серверах, нам розповів станіслав закіров, директор з розвитку інфраструктури vk.

У випадку vk-а це не тільки вконтакте, але і маса інших сервісів, включаючи однокласники, mail.ru, сітімобіл, delivery club і т.д. — підхід до побудови інфраструктури значно змінився за останні кілька років. За вибір апаратної платформи відповідає окрема тестова лабораторія, яка вивчає масу «заліза», в тому числі ще не вийшов. Одним з найважливіших параметрів при виборі є продуктивність на ват, оскільки цей параметр має драматичний вплив на майбутні операційні витрати і, отже, на оцінку tco.

Первинний відбір йде з опорою на синтетичні тести, але потім кандидати потрапляють в руки інженерів, які дивляться як вони справляються з реальними навантаженням, даними і в реальному ж оточенні. З cpu знімається маса метрик, включаючи, наприклад, рівень завантаження, час відгуку, промахи кеша і т.д. Основна вимога — щоб нова система справлялася із завданнями найбільш вимогливих і великих внутрішніх замовників максимально ефективно з точки зору витрат на одиницю корисної продуктивності.

Зайві для менш вимогливих завдань потужності все одно до певної міри утилізуються, в чому допомагає перехід до хмарної моделі (зокрема, контейнеризації і віртуалізації) і програмно визначеним рішенням укупі з грамотною оркестрацією. Власне кажучи, на даному етапі розвитку vk підійшла до логічного кінця — все нові машини мають уніфіковану платформу з єдиним варіантом процесора, на якій будуються і cpu-вузли, і gpu-вузли, і сгд.

Зображення: vk

Поточне покоління серверів базується на двосокетних платформах з intel xeon platinum 8380 (40c/80t, 2,3/3,40 ггц, l3-кеш 60 мбайт, tdp 270 вт). Простіше кажучи, використовується найстарший процесор intel на поточний момент. Cpu тепер тільки один і платформа теж одна. Закуповуються вони все у великих обсягах, що значно зручніше і вигідніше з точки зору обслуговування і дозволяє отримати істотний виграш в ціні. Настільки істотний, що навіть використання двох-трьох платформ з відмінними cpu і периферією в нинішніх умовах і з поточними запитами vk виявляється в середньому дорожче.

І це навіть без урахування додаткових факторів на зразок дозакупки cpu і інших компонентів в майбутньому, адже чим більше використовуваний асортимент, тим важче це буде зробити. Але у кожного гиперскейлера своя, дуже цікава математика. Можна подивитися, наприклад, на дизайн ocp-серверів meta (facebook), а ще краще — на нові платформи aws, яка «досягла вершин». Aws використовує переважно власні цод і активно переходить на платформу з власними ж cpu graviton3. Що і приводить нас до питання про операційні витрати, а точніше про баланс між capex і opex.

Зображення: vk

У vk зараз всього два власних дата-центру — в москві і санкт-петербурзі, а все інше припадає на орендовані майданчики в інших цод, причому далеко не завжди найновіших. Це має свої наслідки. Підвищення щільності розміщення обчислювальних потужностей в рамках одного вузла призводить до необхідності більш складних калькуляцій для живлення і охолодження в рамках стійки і, далі, цод. Так, для нової платформи було вибрано 2u-шасі просто тому, що в нього можна поставити більші вентилятори, знизивши їх швидкість обертання і енергоспоживання, яке швидко зростає в міру збільшення навантаження на «залізо».

Власне кажучи, в сучасних платформах c парою cpu, у яких tdp наближається до 300 вт (в піку ще вище), і іншими компонентами (ще до 200 вт) на харчування тільки вентиляторів може йти ще третина від рівня споживання самого «заліза». При цьому масштабувати харчування з типових для комерційних цод (з їх фактичної середнім навантаженням по потужності, грубо кажучи, на рівні двох третин) 5-7 квт на стійку можна ще відносно просто. А ось охолодження-далеко не завжди. І це ми ще не говорили про системи з прискорювачами, де тільки «кремній» з’їдає від 3 квт.

Вихід? перший шлях-різко знижувати щільність розміщення обладнання в стійках, що найчастіше невигідно з точки зору tco і в своєму цод, і власникам орендованих, особливо коли такі розташовані там, де вартість землі є значною статтею витрат при побудові дата-центру. Крім того, це ускладнює підтримку зв’язності і підвищує витрати на мережеву інфраструктуру. Другий-створювати власні оптимізовані вузли і дата-центри, де вже можна економити просто на масштабах розгортання, як і роблять великі гіперкейлери. Третій-підвищувати ефективність охолодження. А ось як саме, питання окреме.

Підвищувати вироблення холоду для традиційного повітряного охолодження може бути накладно, та й схилити оператора цод (свого або чужого, нового або старого) до установки, скажімо, ще пари-трійки чилерів (а це не тільки зайве місце, але і електрику) не завжди можливо, а часто не реалізується навіть технічно. Компромісний варіант – це сжо, у яких ефективність вище, але які, якщо це не імерсійні системи, можна відносно просто впровадити навіть у вже наявну інфраструктуру. Так, не завжди і не скрізь. Так, капітальні витрати будуть трохи вище, ніж у класичного «повітря», зате в перспективі потенційно можна значно заощадити на операційних.

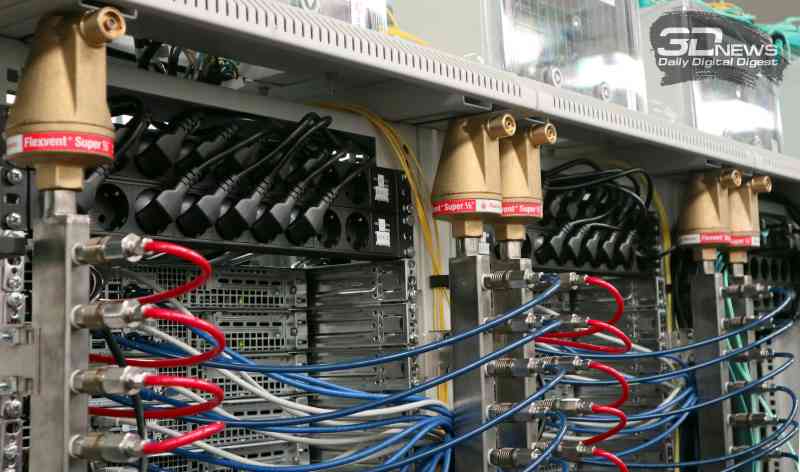

Взагалі кажучи, для кожного окремого випадку треба робити окремі розрахунки, але якщо є можливість протестувати сжо на існуючих потужностях, а в планах є подальше розширення інфраструктури, де без потужних систем з прискорювачами вже ніяк не обійтися, то упускати такий шанс не варто. Рівно така ситуація зараз у vk, яка, зокрема, готується до будівництва третього за рахунком власного цод, який розміститься в підмосковному домодєдово. Для вивчення можливостей практичного застосування сжо vk звернулася до компанії рск, яка створила систему ” під ключ», компоненти власної розробки: насосні блоки, систему розподілу рідини в стійці і водоблоки для cpu з tdp 270+ вт.

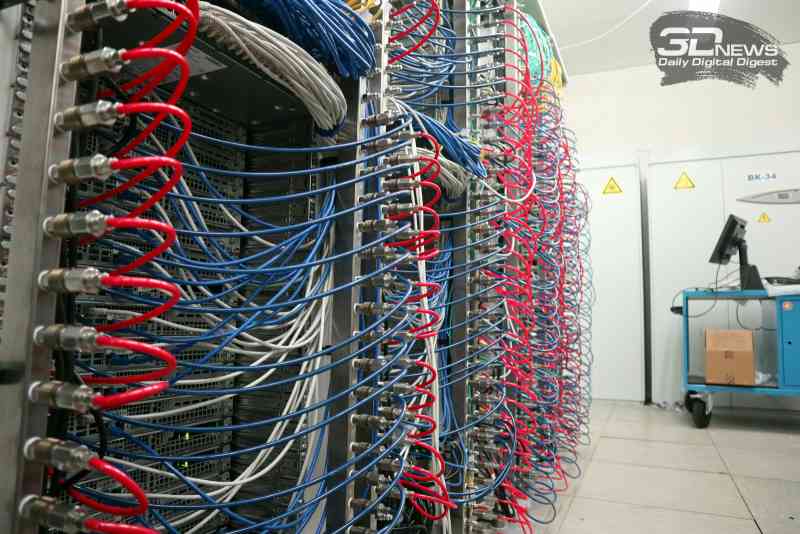

На початку літа 2020 року тестова система була розгорнута в московському дата-центрі vk (далеко не найновішому) — дві стійки з різними типами вузлів на 30 квт сумарно, на кожну з яких доводилося по 5 квт на «повітря» і по 10 квт на «воду». На комутацію систем пішло півдня, причому сжо була в мінімальному варіанті, тобто без резервування. Потім ці машини були включені в загальний пул, і на них запущені (і до цих пір працюють) звичайні продуктові навантаження. Вивчивши особливості поведінки та експлуатації машин і сжо, знайшовши і усунувши всі проблемні місця, а також налагодивши весь програмно-апаратний стек, компанія прийняла рішення розширити тестовий полігон — всього зараз 60 машин в москві і ще 40 в санкт-петербурзі.

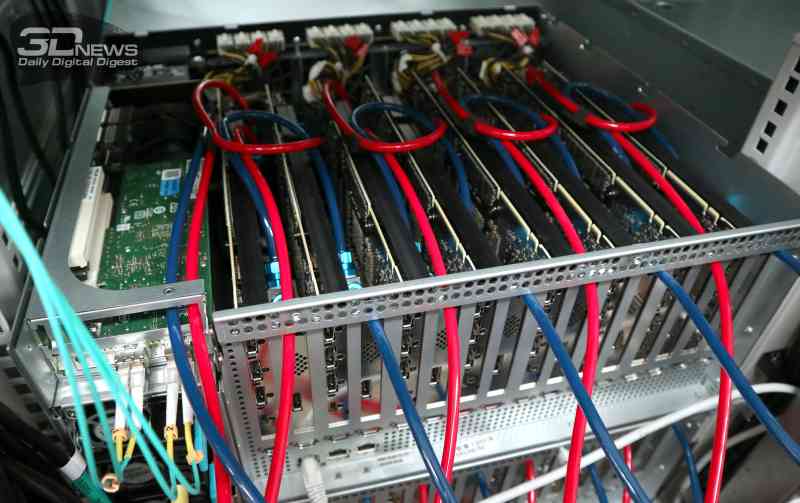

Влітку 2021 року в москві з’явилося ще кілька стійок з сжо в серверах. У тому числі два десятки gpu-вузлів: ті ж два топових cpu + вісім pcie-прискорювачів по 300 вт кожен. При цьому всі гарячі компоненти в таких вузлах охолоджуються рідиною. Сам контур п’ятикратно наростив потужність і отримав резервування: для охолодження рідини встановлені дві градирні, а для створення циркуляції холодоносія — два насосних блоку. Причому насосні блоки рск унікальні-це єдине рішення, що об’єднує насоси внутрішнього і зовнішнього контурів в одному блоці укупі з енергоефективною схемою управління. Вся система охолодження, включаючи градирні і насоси обох контурів, споживає пропорційно кількості встановлених серверів з сжо і реальної теплової навантаженні.

Після оновлення інженерам тестової лабораторії знову довелося помучитися з налагодженням всієї цієї системи на різних рівнях. Починаючи з того, що переклад gpu на сжо набагато складніше, ніж cpu, і закінчуючи створенням розвиненої системи моніторингу, яка дозволила зрозуміти, чому в синтетичних тестах все було добре, а під реальними навантаженнями виникали проблеми. Це важливо, оскільки прискорювачі беруть участь у розподіленому машинному навчанні, і втрата навіть одного з них неприємна.

Заодно було підтверджено, що зі зростанням масштабу впровадження сжо стають все більш і більш вигідним рішенням — кожен кіловат в новій тестовій 100-квт системі з резервуванням обходиться значно дешевше, ніж в старій 20-квт без нього. І вузол з виключно повітряним охолодженням, згідно з тестами, за фактом споживає не менше, ніж з сжо (включаючи і внутрішні, і зовнішні компоненти), аМасштабувати тільки» повітря ” значно дорожче.

Такий гібридний підхід з відбором тепла за допомогою сжо від питомо найбільш гарячих компонентів (на них в середньому припадає 85% по харчуванню і, відповідно, охолодженню в конкретній системі) дозволяє, наприклад, набагато простіше перейти вже на фрикулінг (в тому числі з адіабатикою). Підсумковий коефіцієнт pue становить приблизно 1,1 проти традиційних 1,35–1,5. Тому навіть якщо capex для сжо вище, capex для дата-центру цілком (особливо з урахуванням it-компонентів) може бути нижче, а економія на opex на періоді від 3-5 років і зовсім дозволяє повністю окупити підвищені капітальні витрати.

А саме по собі зниження питомого пікового енергоспоживання дозволяє менше витратити на закупівлю гарантованих потужностей, дбж і генераторів. Крім того, є і цілий ряд додаткових факторів в капітальних витратах. Наприклад, для» води « — це як мінімум вся» сантехніка”, дообладнання вузлів і стійок і т. Д. У разі тільки “повітря” це дуже дорогі радіатори і вентилятори для високих рівнів tdp і більш низька щільність розміщення обладнання в стійках.

У випадку vk розрахунки показують, що впровадження сжо виявляється ефективним за ключовими параметрами рішенням. Це не означає, що у всіх інших буде точно так же. Навіть нинішню платформу можна досить комфортно використовувати в старих цод. Але у vk вже є плани на наступне покоління “заліза”, у якого tdp зростає (cpu 300+ вт, gpu 500+ вт), а ось критична температура падає. І до його появи треба готуватися вже зараз, причому перехід на сжо для них буде ще більш ефективним, ніж в нинішньому поколінні.

А можливість використання саме потрібного (і топового) обладнання важлива для розвитку бізнесу в цілому. Як воно вийде насправді, зараз ніхто не готовий сказати. Поки що в планах оснастити сжо частина майбутнього цод, отримавши досвід дійсно масового розгортання і експлуатації вузлів з «водою», а також решти інфраструктури — наприклад, про сгд і мережу теж не можна забувати. Головне, що страху перед використанням сжо в цод вже немає. Є розуміння слабких місць і єдиних точок відмови, є розуміння, як вирішувати проблеми.

Новим авторам.